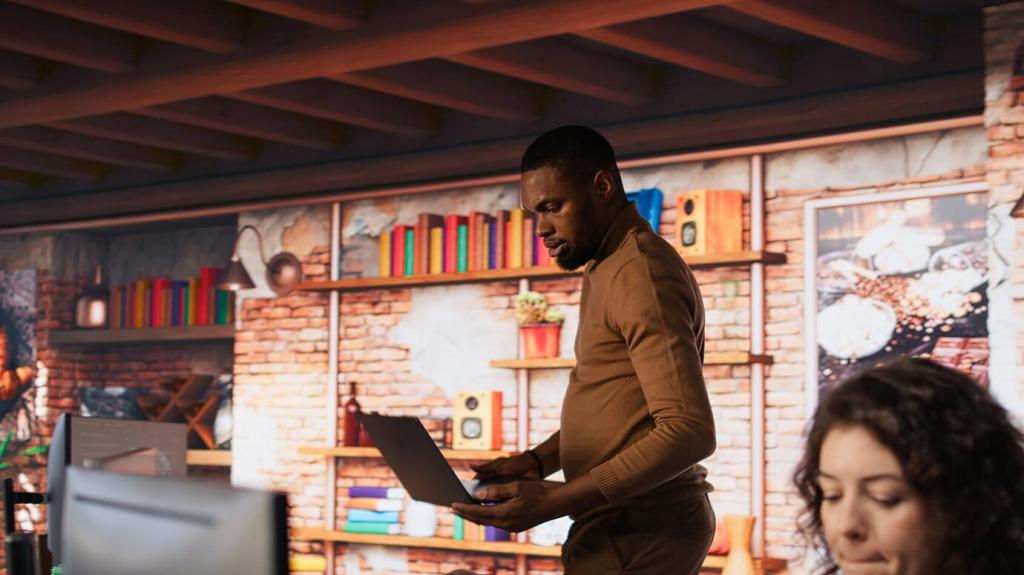

Neuronale Netze verständlich gemacht

Mehrere Schichten lernen Merkmalsabstraktionen, Aktivierungsfunktionen bringen Nichtlinearität, Gewichte speichern Erfahrung. Denke in Bausteinen: Schichten, Merkmale, Entscheidung. Teile deine Anwendungsidee, und wir skizzieren eine einfache Architektur, die realistisch trainierbar und sinnvoll erweiterbar bleibt.

Neuronale Netze verständlich gemacht

Fehler fließen rückwärts durch das Netz, leiten Gewichtsänderungen, der Gradientenabstieg optimiert schrittweise. Lernrate und Mini‑Batch‑Größe beeinflussen Stabilität. Erzähl, wo dein Training schwankt, und wir diskutieren Strategien für ruhigeres, schnelleres Konvergieren ohne Überraschungen.

Neuronale Netze verständlich gemacht

Frühes Stoppen, L1/L2‑Regularisierung, Gewichtsnormierung und Datenvermehrung halten Modelle generalisierungsfähig. Prüfe Lernkurven, nutze Validierung konsequent. Welche Technik hat dir geholfen? Teile Erfahrungen, damit andere aus Erfolgen und Irrwegen lernen und ihre Modelle langlebiger machen.